서울대 컴퓨터공학부 전병곤 교수 연구팀이 GPT-3 연구를 위해 그래픽 처리 장치(GPU) 1천대 규모의 컴퓨팅 자원을 투입하는 등 학계에서 가장 큰 규모의 연구를 이끌어 가고 있다.

GPT-3는 비영리재단 오픈AI가 공개한 자연어 처리 분야 초거대 인공지능 모델이다. 전 교수 연구팀은 GPT-3 수준의 딥러닝 모델 아키텍처를 만들었고, 실제 학습을 통해 얼마나 성능이 나오는지 테스트하며 모델을 고도화 할 예정이다. 관건은 얼마나 많은 GPU를 동원해 효율적으로 빠르게 병력학습 할 수 있는지다. 이때 전 교수 연구팀은 구글 클라우드의 GPU 1천대 규모의 컴퓨팅 자원을 활용한다는 계획이다.

아울러 전병곤 교수는 10년 전 발표한 스마트폰 앱 사용시 얼마나 개인정보 유출이 발생하는지 연구한 논문으로 지난 6일 미국 컴퓨터 학회(ACM) SIGOPS의 명예의 전당상을 수상하는 영예를 안았다. 명예의 전당상은 약 10년 전 발표된 논문 중 현재 가장 많은 영향력을 미친 논문을 선정해 수여하는 상이다.

지디넷코리아는 지난 25일 서울대 전 교수의 연구동에서 그를 만나 GPT-3 연구 계획에 대해 들어봤다. 그는 AI 모델 연구에 대해 “과학이 들어간 아트”라고 표현했다. 연구팀이 구축한 딥러닝 모델 아키텍처를 학습시키는 과정에서 세세하게 구조를 변경하는 고도의 작업이 필요하기 때문이다.

전 교수는 1994년 서울대 전자공학 학사 졸업 후, 1996년 동대학원 전자공학 석사 과정을 밟았다. 2002년 미국 스탠포드 대학에서 컴퓨터 사이언스 석사, 2007년 UC 버클리 대학에서 컴퓨터 사이언스 박사 학위를 취득했다.

이후 국제 컴퓨터 사이언스 학회, 인텔, 야후 리서치, 마이크로소프트 등에서 연구원으로 활동한 후 2013년 서울대 컴퓨터공학부 교수로 부임했다.

다음은 전병곤 교수와의 일문일답.

-ACM SIGOPS 명예의 전당상은 어떤 상인가?

연구를 공유하는 방법은 다양하다. 많은 경우에 논문을 발표하고 연구자들이 논문에 있는 내용을 읽고 적용하고 후속연구를 하는 식으로 지식이 전파된다. 그런데 그 논문이 나오자 마자는 얼마나 큰 영향이 있을지 모른다.

명예의 전당 상은 논문이 나온 다음에 한 10~11년 정도 뒤의 영향력을 보고 주는 상이다. 논문의 영향력을 객관적으로 본다. 저명한 분들이 10년 전에 관련 분야 연구들을 다 놓고 어떤 논문 한두 편이 정말 영향력이 큰지 심사한다. 과거에 윈도 같은 운영체제들의 시초인 유닉스 개발자도 명예의 전당상을 받은 적 있다.

이번엔 우리 연구팀이 2010년 발표한 테인트드로이드 연구 논문과 취리히 대학 교수가 쓴 멀티커널 논문이 명예의 전당상을 받았다. 당시 우리 연구팀은 세계 최초로 스마트폰에서 개인 정보의 흐름을 실시간 추적해 개인 정보를 보호하는 기술을 제안했다. 명예의 전당상을 받을 때는 논문 인용수가 3천800회였는데, 지금은 3천900정도 인용됐다. 논문을 인용해서 연구를 진행하는 분들이다. 우리가 만든 코드도 공개했기 때문에 그 코드도 많이 활용되고 있다.

-테인트드로이드 연구에 대해 설명해 달라.

그당시 나와 함께 연구하던 분들이 상당히 흥미를 가지고 본 주제가 ‘스마트폰 앱 사용시 개인정보가 얼마나 안전하게 보호되나’였다. 아이폰이 나온지 얼마 안됐고 안드로이드 개발자 버전 ‘ADP1’을 만들어 배포하기 시작했을 때다. ADP1에서 전체 수행되는 안드로이드 소프트웨어 스택이 전체 공개됐었다. 나와 함께 연구하는 분들이 보안 쪽에 관심이 많은 사람들이었다. ADP1에서 앱의 보안 특성이 어떻게 되는지 같이 보면 좋겠다고 생각해 2009년부터 연구를 시작했다.

그 당시 한창 구글플레이, 애플 앱스토어에서 상당히 다양한 앱들이 나와 사람들이 쓰기 시작했을 때다. 우리의 궁금중을 풀기 위해서는 스마트폰에서 개인정보가 어떻게 사용되는지 소프트웨어 전체 스택을 따라갈 수 있는 시스템을 만들어야 했다. 관련해 테인트트래킹이란 기술이 상당히 큰 기여를 했다. 두 번째로 큰 기여를 한 기술이 앱에서 개인정보를 어떻게 쓰고 있는지 확인하는 기술이었다. 상당수의 많은 앱들이 개인정보를 유출하고 있는 것을 봤다. 정보다 어디로 나갔는지 볼 수 있었으며, 앱에서 다른 앱으로 보내는 모습도 관찰할 수 있다. 저장했다 보내는 것도 다 볼 수 있는 시스템이었다. 이같은 상황들을 발견하고 우리는 그 이후 심각성을 느껴 연구를 시작했다.

-개인정보 유출은 주로 어떤 부분에서 발생했나?

지금도 사용자들이 앱을 깔면 어떤 권한이 필요하다는 걸 확인할 수 있다. 나쁜 의도를 가지고 짠 앱에서 사용자가 개인정보 활용 허가를 내줄 경우, 많은 경우 광고 라이브러리를 통해 유출의 단초가 된다. 그 라이브러리에서 개인정보를 광고회사로 보낸다. 정보 유출을 막고자 한다면 안드로이드 소프트웨어 자체에서 우리가 제안한 기법들을 사용할 수 있다.

이용자가 개인정보 수집 및 활용에 대해 동의를 했으니 법률상으로는 문제가 없다고 할 수 있는데, 많은 정보들 가운데서 세세하게 모두 동의를 한 것은 아닐 수 있다. 그리고 시스템적으로도 다양한 정보들의 레벨을 세세하게 컨트롤 할 수 없다.

우리 연구는 회사들이 개인정보를 오용하는지 밝히는데 초점을 맞췄다. 연구 전엔 회사들이 얼마나 심각하게 오용하고 있는지도 몰랐던 때다. 적어도 오용을 하고 있는지를 밝혔고, 그 다음 어떻게 해야 하는지 방안을 제언했다.

-서울대 교수 부임 이후 어떤 연구에 집중하고 있나?

서울대 교수로 온지는 10년이 안됐다. 2013년 가을부터 시작했다. 그전엔 미국 실리콘밸리 마이크로소프트 연구원으로 있었다. 마이크로소프트와는 지금도 협력하는 관계다. 내가 서울대 AI 연구원의 부원장을 하고 있다. 이 연구원은 경쟁력 있는 연구를 하기 위해 독자적으로 뛰어난 교수와 학생들이 모여 협업하는 곳이다. 이를 위해 마이크로소프트, 구글, 페이스북, 아마존 등 중요한 기업들과 협력하고 있다. 국내 기업으로는 삼성, 네이버와도 협력한다.

컴퓨터 사이언스 분야뿐 아니라 다양한 분야들을 동시에 보고 함께 연구하고 있다. 인공지능, 분산 시스템, 페이스북이나 구글 뒤에 인프라스트럭처 서비스 같은 분야 등에도 관심이 있다. 이들 서비스의 소프트웨어는 어떻게 만드는지, 인공지능 계산을 어떻게 효율적으로 하는지 등등을 많이 보고 있다.

-최근 거둔 다른 연구 성과로는 무엇이 있나?

사실 ACM SIGOPS 명예의 전당상 이후에 최근인 구글 리서치 어워드도 수상했다. 구글 측에 기여했다기 보다는 인공지능 소프트웨어에서 새로운 개념을 구현했을 때 이 연구상을 준다. 우리 연구팀은 딥러닝 소프트웨어에 대해 연구했다.

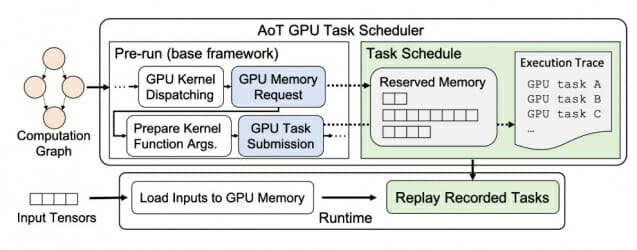

딥러닝 소프트웨어는 크게 두 분류로 나뉜다. 쉽게 말해 하나는 개발자가 쉽게 인공지능 모델을 개발할 수 있는 대신 성능은 낮고, 또 하나는 개발자가 개발하기는 까다로운데 성능은 좋은 편이다. 우리는 이 두 범주를 결합한 소프트웨어를 만들어 양 쪽의 장점을 모두 가질 수 있도록 했다. 개발자가 쉽게 개발하고 훨씬 좋은 성능을 낼 수 있게 된 것이다. 가령 자연어 토큰에 대한 처리나, 이미지 모델 학습 같은 인공지능 계산을 할 때의 성능을 뜻한다.

-딥러닝 모델을 효율화 한다는 점에서 전 교수가 최근 연구한 ‘님블’과 비슷한 것 같다. 구글에서 수상한 딥러닝 모델과는 무엇이 다른가?

구글에서 수상한 모델은 님블보다 보다 상위 계층의 소프트웨어라 할 수 있다. 님블은 반복적인 작업과 GPU 병렬 처리를 효율적을 할 수 있는 딥러닝 프레임워크다. 인공지능 학습과 추론 수행시 기존 시스템 대비 최대 22배 빠른 성과를 나타냈다.

기존엔 딥러닝 계산을 빠르게 하기 위해 GPU를 가속기를 사용해왔다. 먼저 GPU 단으로 가기 전에 우리는 소프트웨어들이 비슷한 작업을 계속 반복하는 것을 발견했다. 그래서 반복 작업을 자동으로 걷어내 한 번에 처리할 수 있도록 했다. 실제로 수행시에는 GPU 양산하는 부분만 바로 넘어갈 수 있도록 했다.

또 다른 중요 포인트는 GPU에서 병렬로 처리하는 걸 최대한 더 잘할 수 있도록 만들었다. 즉 좀더 아래 계층으로 내려가서, GPU 등 하드웨어와 직접 관련된 부분을 최적화 했다고 볼 수 있다. 파이토치 프레임워크로 짠 모델은 통상 오래걸리고 GPU를 효율적으로 못쓰는 것으로 알려져있었는데, 님블은 이를 자동화해 효율화 할 수 있도록 했다. 이처럼 우리 연구 팀은 전체 인공지능 소프트웨어 스택 전체에 걸쳐서 모든 걸 다 보고 있다.

-요즘 한창 진행 중인 연구에 대해 설명해 달라.

요즘 연구 분야는 마이크로소프트 연구원 때부터 계속 봐온 머신러닝, 인공지능 관련 소프트웨어들이다. 최근엔 아주 큰 스케일의 인공지능 모델인 GPT-3을 빠르게 분산학습하고 추론하는 방법에 대해 연구 중이다. 그런 모델을 만들어서 서비스화 하는 걸 목표로 한다. 지금 이 분야에서 훌륭한 연구실 학생들과 함께 연구하고 있다. 이에 대한 것으로 스타트업도 창업할 계획을 가지고 있다. 이제 막 창업을 준비하는 단계여서 학교 측 지원 같은 것은 추후 논의해봐야 한다.

오픈AI에서 GPT-3 모델을 아직 공개하지 않았다. 오픈AI CEO는 테슬라 대표로 있는 일론 머스크와 Y컴비네이터 사장 하다 나온 샘 알츠만이다. 비영리 조직으로 오픈AI가 관심 있는 것은 보다 일반적인 인공지능 만들자는 것이다. GPT-3는 자연어 처리에 대한 것이다.

우리의 목표는 모델의 계산량과 데이터셋을 늘려 결국 모델 성능을 높이려는 것이다. 스택이 공개된 GPT-2의 경우 15억파라미터 규모다. GPT-3는 1천750억파라미터다. 파라미터란 모델 크기를 표현하는 단위라고 보면 된다. GPT-3는 기존과는 비교가 안 될 만큼 큰 모델이다. 모델이 커지다보니 학습하는 것도 고도의 분산학습과 추론과정이 필요하다. 최대한 많은 GPU를 사용해 빠르게 모델을 만들어내고자 한다. 우리 연구팀은 관련된 기술을 개발해 서비스화 하면 좋겠다는 생각을 가지고 있다. 학계에서도 충분히 큰 규모의 연구를 할 수 있다는 걸 시도해보고 싶었는데, 이를 스타트업 형태로 구현하고자 한다.

-이 연구를 위해 어느정도 규모의 GPU를 마련했나?

모델도 크고 데이터도 많아서 연구실 내 컴퓨터 클러스터로 하기엔 한계가 있다. 우리는 클라우드 활용하고 있다. 클라우드 상에서 1천개 이상의 GPU 사용할 수 있도록 마련했다. 아마존, 구글, 마이크로소프트 세 개 회사의 클라우드를 쓰고 있는데, 이번 연구와 관련해서 사용하는 클라우드는 구글이다. 다른 연구로 AWS와 애저도 다 많이 사용하고 있다.

국내에서 GPU 1천개 이상의 규모로 학습하는 대학 연구실은 없을 것이고 기업도 아직 잘 들어보지 못했다. 그런데 최근 기사를 봤겠지만 업계에서 GPT-3에 관심 상당히 많고. 엔비디아의 최신 수퍼컴퓨터인 슈퍼팟(POD)이란걸 아예 구입하는 곳도 있다고 한다. 슈퍼팟은 최근에 엔비디아에서 나온 A100 1천500개가 달린 하이퍼클러스터인데, 그 위에서 개발을 하겠다고 발표한 곳도 있다. 슈퍼팟은 아마 100억~300억원 할 거라 생각하는데, 그만큼 GPT-3 연구를 위해 다들 엄청나게 투자하고 있다.

-컴퓨터 자원은 확보했는데, 데이터는 어떻게 구하나?

GPT-3는 자연어 처리 모델이다. 많은 연구자들이 그 모델을 이미지 처리 분야에도 적용하기 시작했다. 이를 트랜스포머 모델이라 부른다. 이미지에 적용해서 좋은 결과를 보이기 시작해서 앞으로 다른 분야에도 활용될 수 있을 것으로 보인다. 일단은 그 모델을 학습하기 위해서 어떤 데이터를 입력으로 줬는지가 중요하다.

먼저 우리가 자연어처리 모델을 구상하기 위해선 영어로 지식을 표현하는 데이터들이 필요한데, 이들은 웹상에 널려있다. 자연어처리 연구를 위해 어떤 특화된 데이터를 사용할 필욘 없다. 이 모델 자체가 한번 만들어 놓으면 그 다음에 사용할 때 특정 데이터를 다시 학습해서 사용하는 게 아니라, 몇 개 예시만 보여주고도 답을 낼 수 있게 설계됐다. 때문에 특별한 분야의 데이터로 학습할 필요가 없다. 이런 장점 때문에 사람들이 많은 관심을 보이고 있다.

-GPT-3와 관련한 전 교수 연구팀의 딥러닝 모델은 학습하는데 얼마나 걸리나?

딥러닝 모델이 한 번 학습하는데 엔비디아의 V100이란 GPU를 한 개 쓸 경우 355년이 걸린다. 그런데 당연히 GPU 하나로 학습하면 말이 안 되고 여러 개 써서 학습해야 한다. 이를 병렬학습이라 한다. 병렬화 한 효과가 정말 이론적으로 잘될 경우, V100 355개를 쓰면 딥러닝 학습 소요 기간은 1년으로 줄어 든다. 우리 연구팀이 GPU를 1천개 쓰면 딥러닝 모델 한 번 학습하는데 4개월 정도 걸리지 않을까 싶다. 그 기간 동안 기계가 죽는 일 없이, 안정적으로 작업을 수행한다면 말이다.

GPU를 병렬로 사용할을 때 GPU 개수에 효율이 정비례 할 수 있도록 만드는 게 핵심 기술이 될 것이다. 그런데 완전 정비례하는 건 쉽지 않기 때문에 리니어(비례)하게 증가하긴 어렵다. 최적의 효율성을 이끌어내기 위해 가장 밑단의 하드웨어에서부터 해서 사용하는 소프트웨어까지 전반적으로 봐야 한다.

GPT-3 아키테처의 세세한 부분까지는 알지 못하더라도 어떤 식의 구조를 가지고 있다는 것은 안다. 우리가 준비한 모델 아키텍처는 이미 있고, 실제 학습을 통해 얼마나 성능이 나오는지 확인하는 작업을 거쳐야 한다. 모델을 학습하면서 중간 중간 이 모델이 얼마나 성능을 내는지 보는 일종의 벤치마크 테스트를 거친다. 연구하면서도 모델 구조를 바꿀 수 있다.

세세한 부분을 바꾸기도 하고, 완전히 새로운 아키텍처를 만들 수도 있다. AI 모델 연구라는 게 이런 식이다. 어떤 모델이 주어진 상황에서 데이터셋을 주고 학습하면, 목표한 값대로 파라미터 값들이 수렴하지 측정한다. 이런 학습하는 과정들을 보면 AI 모델 연구는 ‘과학이 들어간 아트’라고 볼 수 있다.

-국내 AI 관련 기업들의 기술수준은 어떻다고 평가하나?

기업마다 강점이 다르며, 내가 기업의 수준을 판단하기엔 적당한 거 같지 않다. 상대적으로 아무래도 구글, 마이크로소프트 등에 일단 인재들이 더 많은 건 사실이다. 국내에도 좋은 인공지능 연구자들이 많지만 그럼에도 더 많은 인재들이 나와야 하는 건 맞다. 학교에서 관련분야의 학생들을 키우는 것이 중요하다.

관련해 아직도 컴퓨터공학과 정원이 크게 늘지 못하고 있다. 서울대에서는 나름대로 그런 문제를 해결하기 위해서 AI 연합전공이란 학부 전공을 만들었다. (정원을 늘리지 못하니) AI 협동전공이나 자유전공학부에서 컴퓨터공학에 집중해 공부하는 사람들이 많이 있다. 복수전공이나 부전공으로 컴퓨터공학을 택하는 학생들도 많이 있다. 제한된 정원에서 저희가 최대한 많은 학생들을 키우려고 노력하고 있다. 국가가 대학의 컴퓨터공학과 정원을 많이 늘려주면 도움이 될 것 같다.

-전 교수가 부원장으로 있는 서울대 AI연구원은 어떤 곳인가?

관련기사

- 연구기관 ETRI, AI 아카데미 100일 운영해보니…2020.11.25

- 네이버클라우드·흥국화재, AI기반 보험 서비스 확대2020.11.23

- 일론 머스크, MS GPT-3 독점 라이선스 계약 비판2020.09.27

- MS연구소, 한국인공지능학회와 공동학술대회 개최2020.11.17

서울대 본부 산하의 AI연구원이다. AI 연구에 관심이 있는 서울대 교수들이 협력해서 시너지를 내고자 만든 연구소다. 현재 교원의 10%가 저희 연구원에 속해있다. AI연구원을 통해서 교수들이 모이는 효과가 있다. 코어 AI에 대한 연구뿐 아니라, 서울대가 종합대학으로서 다양한 분야의 교수들이 있기 때문에 AI에 전문 분야를 융합한 ‘AI+X’의 연구도 할 수 있을 것이다. AI연구원은 이같은 모든 AI 연구를 총괄하고, 외부와 협력하는 허브로서 역할을 하고 있다.

올해 하계 인턴은 내가 처음으로 설계해 시작한 프로그램이다. 나도 과거에 마이크로소프트에서 인턴했던 좋은 경험이 있기 때문에 학생들에게도 그런 기회를 만들어주고 싶었다. 우리가 예상했던 것보다 많은 관심을 받고 우수한 학생들도 많이 알게 됐다. 내년 2회를 준비할 때는 더 많은 학생들에게 기회를 줄 수 있도록 프로그램을 설계하고 싶다. 함께 연구하면서 아이디어를 공유하고, 같이 더 어려운 문제를 풀 수 있었으면 좋겠다.