퍼블릭 클라우드 서비스 업체의 경쟁이 하드웨어로 옮겨갔다. 딥러닝 등 인공지능(AI) 기반 소프트웨어를 위한 최적의 인프라를 제공하려는 경쟁 때문이다.

딥러닝 같은 기술은 기존 중앙처리장치(CPU) 외에 GPU, FPGA, ASIC 등 별도 하드웨어를 활용할 때 더 효과적이란 게 입증되고 있다.

AI에 최적화된 하드웨어로 가장 널리 쓰이는 건 GPU다. 엔비디아가 특수를 톡톡히 누리고 있다. 아마존웹서비스, 마이크로소프트, 구글 등 퍼블릭 클라우드 3사는 GPU 기반 서비스를 제공하고 있다.

이들 3사는 GPU에서 한발 더 나아간 제2의 차별화 요소를 만들려 경쟁하고 있다. MS가 일찌감치 FPGA를 AI 알고리즘에 활용하는데 투자해왔다. AWS도 작년 FPGA 가속을 클라우드 서비스 중 하나로 제공하고 있다. 구글은 아예 딥러닝에 최적화한 자체적인 ASIC을 설계했다.

이들이 GPU, FPGA, ASIC 등에 관심을 가지는 이유는 크게 성능, 효율성, 비용 때문이다. 가속 장치는 특정 연산만 수행하는 별도 요소를 둠으로써 성능을 높일 수 있고, 전력 소모를 획기적으로 줄이는 한편, 내부 운영 비용도 감축할 수 있다.

■ MS, FPGA칩 활용해 효율성 높여

MS는 지난 수년간 FPGA 칩을 이용해 빙과 애저의 성능, 효율성을 높여왔다. MS는 여러 워크로드 가운데 머신러닝 등 인공지능(AI) 관련 작업에 FPGA를 활용하는데 주력했다.

MS는 내부 성과를 외부 서비스로 공개할 계획이다. FPGA 하드웨어를 애저 클라우드 서비스의 인스턴스 옵션으로 제공하겠다는 것이다.

마크 루시노비치 MS 클라우드 CTO는 지난 4월 빌드 컨퍼런스에서 "하드웨어 마이크로서비스를 애저 클라우드를 통해 제공할 것"이라며 "몇몇 보안과 기타 이슈를 해결하면 완벽히 설정가능한 클라우드를 가지게 될 것"이라고 밝혔다. 그는 "이는 AI 클라우드의 핵심"이라며 "FPGA의 힘으로 AI 민주화로 중대한 진일보를 할 것"이라고 강조했다.

FPGA는 특정 기능을 수행할 수 있도록 설계된 마이크로프로세서다. 각 FPGA 칩은 한 조각 정도의 코드만 실행하게 된다. FPGA는 8비트나 16비트 수준의 낮은 정확성을 요하는 알고리즘에 적합한 것으로 알려져 있다.

FPGA는 CPU나 GPU 같은 다목적 마이크로프로세서의 프로그래밍과 비교해 더 높은 기술 수준을 요한다. 오픈CL을 비롯해, 기타 FPGA 친화적인 컴파일러 기술과 앱이 나오고 있지만, 여전히 모든 개발자가 부담없이 시도하기엔 어렵다.

MS는 FPGA 프로그래밍을 위한 프레임워크와 개발 툴, 혹은 서비스를 내놓을 예정이다. MS는 내년께 관련 서비스를 내놓는다는 목표를 공식화했다.

MS는 최근 모든 자체 데이터센터 내 애저 서버에 FPGA를 추가했다. 딥러닝을 위한 DNN 환경에 FPGA 기반의 하드웨어 마이크로서비스를 적용하는 ‘프로젝트 브레인웨이브’도 진행중이다.

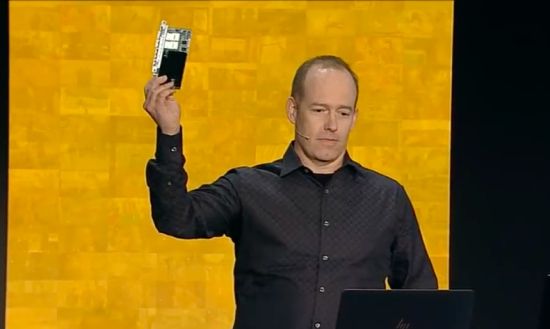

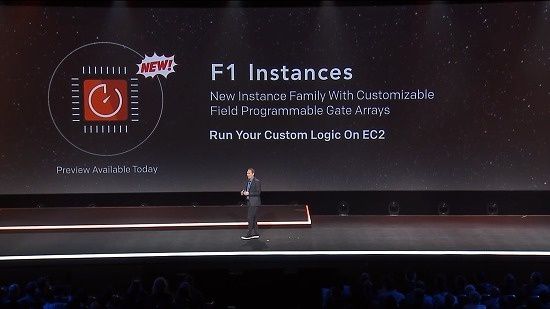

현재 아마존웹서비스가 FPGA EC2 F1 인스턴스란 명칭의 FPGA 가속 기능을 제공하고 있다. 이는 자일링스의 FPGA를 활용한다. FPGA를 위한 하드웨어 개발도구도 제공한다.

■ 구글, 머신러닝 라이브버리로 텐서플로우 활용

구글은 머신러닝과 딥러닝을 위한 라이브러리로 텐서플로우를 활용한다. 구글 텐서플로우는 ‘텐서프로세싱유닛(TPU)’란 자체 개발된 프로세서로 더 강력한 성능을 발휘한다.

관련기사

- 가벼워진 '알파고'…구글 전용칩 1개로 작동2017.08.02

- AWS, 7개의 신규 EC2 서비스 출시2017.08.02

- 인공지능 위한 하드웨어 준비 마친 글로벌 IT 공룡들2017.08.02

- MS는 왜 FPGA에 공을 들이나2017.08.02

TPU는 지난 5월 딥마인드의 알파고와 바둑기사 커제의 바둑 대결에서 성능을 입증했다. 알파고는 TPU 인프라를 활용해 작년보다 더 무서운 위력을 과시했다.

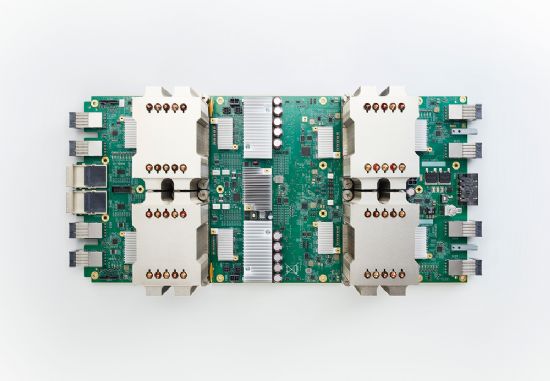

구글 클라우드 TPU는 프로세서 모듈 1개에 연산성능 45테라플롭스(TFLOPS)짜리 칩 4개를 얹어 180TFLOPS 성능을 낸다. 또 모듈 1개는 64기가바이트(GB) 메모리 대역폭을 지원한다. 1년전 소개된 1세대 TPU의 계보를 잇는 애플리케이션 특화 집적회로(ASIC) 즉 맞춤형 프로세서다.