IBM이 120페타바이트(PB), 즉 1억2천만기가바이트(GB) 규모의 빅데이터 분석용 스토리지를 구축하는 것으로 알려져 화제다.

미국 씨넷은 지난 27일 IBM이 평범한 하드디스크드라이브(HDD) 20만대를 동원한 인프라와 슈퍼컴퓨터에 쓰던 데이터 접근 기술을 응용해 '일기예보'같은 복잡한 연산을 처리하는 방법을 연구한다고 보도했다. 이 소식은 미국 매사추세츠공대(MIT)가 발행하는 기술전문블로그 '테크놀로지리뷰'의 '이번주 MIT 기술 리뷰'에 게재됐다.

PB는 잘 쓰이지 않는 단위기 때문에 용량이 쉽사리 와닿지 않을 수 있다. 테크놀로지리뷰의 표현을 빌리면 120PB는 MP3 형식의 음악 파일 하나를 5메가바이트(MB)로 간주할 때 '240억'곡을 저장할 수 있는 공간이다.

보도에 따르면 IBM이 연구중인 기술은 약 1조개 파일을 보관해놓은 복잡한 시스템에서 '기후와 날씨 예측 모델' 처럼 더 강력한 시뮬레이션 연산을 수행할 수 있는 공간을 제공할 전망이다.

해당 시스템은 IBM 알메이든 연구소에서 개발된 '제너럴 패러렐 파일 시스템(GPFS)'에 기반한다. GPFS는 슈퍼컴퓨터에서 데이터 접근을 가속시킬 목적으로 나온 파일 저장 기술이다. 이 환경에선 파일 하나를 다룰 때도 동시에 그 여러 부분을 읽거나 쓸 수 있다. 단일 파일이 여러 디스크에 나뉘어 저장되기 때문이다.

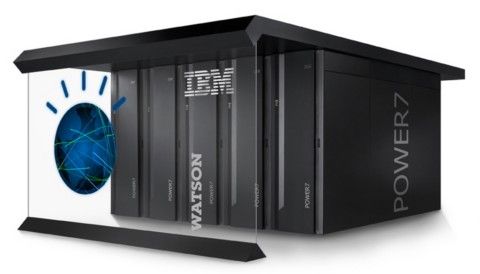

즉 GPFS는 파일에 저장된 데이터에 접근할 때 더 빠른 속도를 제공하는 클러스터 아키텍처를 구성하도록 돕는다. 데이터를 여러 스토리지 장치에 자동적으로 흩어뜨려 저장하는 분산 클러스터 환경에서 돌아가는 스토리지를 통해 고성능을 구현할 수 있다는 설명이다. 이덕분에 IBM이 자랑하는 슈퍼컴퓨터 '왓슨'의 스토리지 엔진에도 탑재돼 있다고 씨넷은 덧붙였다.

관련기사

- IBM, 4배 빨라진 XIV 스토리지 출시2011.08.29

- IBM 슈퍼컴 '왓슨,' 유닉스 서버로 재탄생2011.08.29

- 슈퍼컴 '왓슨'에 가상슈퍼컴퓨터 관심 폭증2011.08.29

- IBM, 세계 최고속 슈퍼컴 제작...성능은?2011.08.29

보도에 따르면 페이스북에게 120PB 용량을 제공해 일일 로그 기록 공간으로 쓸 경우 4천915일동안 저장할 수 있다. 다시 말해 13년5개월정도 버틸만한 크기다. 이는 지난 2009년 당시 기준으로 페이스북의 일일 로그 발생량이 25테라바이트(TB), 즉 2만5천GB였던 점에 기반한다.

그러나 씨넷은 온라인과 오프라인 환경에서 데이터가 기하급수적으로 늘어나는 상황을 지켜볼 때 120PB라는 용량이 5년 안에 훨씬 더 실제 쓰일만한 단위로 다가올 것이라고 지적했다.