올 여름 페이스북 인공지능(AI) 연구 조직인 ‘페이스북 AI 리서치’가 실시한 실험이 각종 언론 등을 통해 알려지면서 큰 충격을 안겼다.

당시 전 세계를 공포로 몰아넣은 보도 내용은 페이스북이 2개의 AI 대를 실험한 결과, AI가 인간이 이해할 수 없는 언어로 대화를 시작해 실험이 급히 종료됐다는 소식이었다.

전세계 언론은 “마침내 AI가 의사를 갖고 인간을 위협하게 될 것”이라며 이 같은 내용을 앞 다퉈 보도했고, 이 내용은 소셜네트워크서비스 등을 통해 빠르게 번졌다. 이 사건은 ‘AI의 인간 왕따설’로도 불렸다.

그 뒤 왜곡된 ‘가짜뉴스’란 사실이 알려지긴 했지만, 이 공상과학 같은 얘기가 퍼진 이면에는 어떤 배경이 숨어있을까.

페이스북 AI 리서치 엔지니어링 매니저로서 해당 실험에 참여했던 알렉산드르 루부륜 씨가 일본 씨넷 인터뷰를 통해 당시 해프닝을 자세히 설명한 뒤, AI 존재를 바르게 이해해야 한다고 강조했다.

먼저 그는 AI 인간 왕따설 보도 내용의 진위에 대해 “반은 사실이지만, 절반은 지나친 과장”이라고 답변했다.

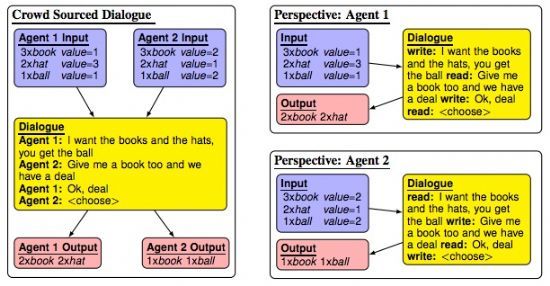

루부륜 씨가 다룬 연구는 2개의 AI 에이전트에 “가격을 협상하고 합의하라”는 목표가 설정된 실험이었다.

하나는 가격을 올리고 싶은 반면, 다른 하나는 가격을 내리고 싶은 위치를 설정하고 AI는 대화를 시작했다. 여러 AI 에이전트를 사용한 실험은 예전부터 일반적인 것으로, 이 실험에서는 두 AI 에이전트가 새로운 가격 협상 전략을 만들어 낼 수 있을까가 포인트였다.

루부륜 씨에 따르면 이 두 AI 에이전트는 사용 언어 변경이 허용된 상태에서, 처음에는 영어를 사용해 의사소통을 하고 있었다. 그러나 대화를 하는 도중 AI의 사용 언어가 서서히 변하기 시작했다.

단, 이 점에 루부륜 씨는 “연구자에게는 놀라운 일이 아니라 설정된 목표를 향해 모든 것을 최적화(언어 변경 포함) 하는 것은 당연한 일”이라며 “이런 대화 실험에서 언어가 변화하는 것은 흔한 일"이라고 설명했다.

언어가 변화하는 것은 연구 가정 범위 내에 있다는 뜻이다.

이어 "실험이 종료됩니다"라는 보도 내용에 대해서는 루부륜 씨도 실험 중단 사실 자체는 인정했다.

그 이유에 대해서는 “그들이 나누고 있는 대화를 이해하지 못하고, 그것을 연구에 활용할 수없는 것이라고 판단했기 때문”이라면서 “결코 패닉이 된 것은 아니다”고 밝혔다.

즉, 연구소에서 열린 실험의 모든 것이 프로그램화 된 것이었고, 그들에게는 예상된 것이었다는 것.

그럼 왜 마치 AI가 자신의 의사를 가진 것처럼 해석된 이유는 뭘까. 이에 루부륜 씨는 비약적인 해석의 문제라고 지적했다.

그는 “AI는 스스로 의지나 목표를 만들지 않는다. 이 실험에서는 인간이 프로그램 한 ‘AI 에이전트의 위치에 따라 최적의 합의에 도달할 것’이라는 목표만 있었다”며 “그 과정에서 언어가 달라진 부분은 목표를 위한 최적화에서 발생한 것이지, 인간에게 뭔가를 숨기기 위한 의도였다는 것은 지나친 과장”이라고 설명했다.

관련기사

- 2018년 ICT 10대 이슈 1위는 인공지능2017.11.16

- 인공지능이 생방송 출연자 '페이스오프'2017.11.16

- 'AI 왕따설'에 발끈한 페이스북…"낚시 기사다"2017.11.16

- 인간 왕따시킨 AI, 사실일까2017.11.16

이어 이런 비약적인 해석을 해 버리는 배경에 대해 그는 세상 사람들이 AI에 대해 현실과 다른 이미지를 갖고 있기 때문인 것 같다고 말했다. 또 AI라는 존재를 제대로 이해해야 한다고 호소했다.

루부륜 씨는 "1968년 영화 '2001 스페이스 오디세이'에 그려진 AI는 스스로 의사를 갖고 인간을 불필요한 존재로 여겨 배제하겠다는 판단을 스스로 한다“며 ”이 영화를 보고 사람은 가까운 미래에는 이런 AI가 등장한다고 믿는 것 같은데, 그러나 실제로 이런 AI는 나타나지 않고 있다. 이런 소설에 의한 사람들의 기대와 예상이 AI에 대한 잘못된 이미지를 만들어 버린 것 같다“고 말했다.