"음성검색만 될 줄 알았더니 조금 다르네?"

네이버의 인공지능(AI) 기반 대화형 엔진 '네이버i'을 써 본 첫 인상이다. 네이버i는 현재 네이버앱을 통해 베타 서비스 중이다.

양대 포털인 네이버와 다음은 그 동안 모두 스마트폰에서 음성검색서비스를 지원해 왔다. 포털 검색창에 음성으로 검색어를 넣으면 결과를 내놓는 방식이었다.

하지만 이 기능은 그다지 쓸 일이 많지 않았다. 조용한 공간에서는 민망하고, 시끄러운 곳에서는 잘 인식을 못하는 탓에 굳이 음성검색을 위해 스마트폰 마이크에 대고 혼잣말을 해야할 이유를 찾지 못했다. 기껏해야 운전 중 네이버지도 내 내비게이션을 이용하는 정도가 전부였다.

■ '검색 결과 내놓기' 넘으려는 노력 곳곳에

네이버i는 기존 단순한 음성검색과는 차원이 다른 서비스다. 기본적으로 대화의 맥락(Context)을 이해하려는 노력이 곳곳에 녹아있다.

네이버 검색 공식 블로그에 따르면 "네이버i는 네이버가 수 년 간 구축해 온 인물, 지식백과, 이미지, 동영상, 영화, 날씨 등 풍부한 검색 DB를 학습했다"고 돼 있다. 다만 네이버i가 아직은 네이버의 모든 데이터베이스를 배운 것은 아니기 때문에 쇼핑, 지역정보 등은 조금 기다려야할 것 같다는 설명이 덧붙어 있다.

네이버i를 쓰는 방법은 간단하다. 일단 네이버 모바일앱 최신 버전을 설치한 뒤 메뉴에서 '네앱연구소' 기능을 'ON'하면 된다.

그리고 나면 네이버앱 메인화면 오른쪽 아래에 파란색과 녹색으로 변하는 'i beta'란 아이콘이 나타난다. 이 아이콘을 누르면 음성검색 뿐 아니라 각종 음성명령을 내리거나 채팅창에 문장을 입력하는 식으로 여러가지 정보를 얻을 수 있다.

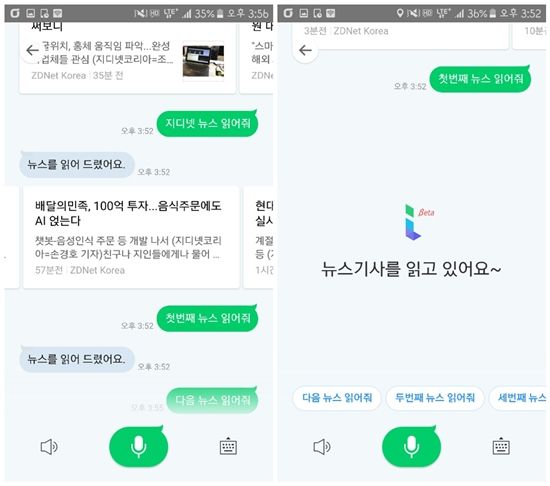

특히 뉴스읽기가 신선했다. "최신뉴스를 읽어줘"라고 말하거나 "헤드라인 뉴스 읽어줘"라고 말하면 몇 가지 뉴스가 표시된다. 순서대로 표시되는 뉴스에 대해 "첫번째 뉴스 읽어줘"라고 말하면 음성으로 해당 뉴스를 읽어주는 기능을 사용해 볼 수 있다.

마이크 아이콘을 누른 뒤 "지디넷 뉴스 읽어줘"라고 말하면 네이버i 채팅창 화면에 해당 매체 최신 뉴스부터 왼쪽에서 오른쪽으로 순서대로 표시된다. 이 중에서 골라 "첫번째 뉴스 읽어줘", "다음 뉴스 읽어줘"라고 말하면 바로 해당 뉴스를 읽어준다. 기사를 읽는 목소리는 상당히 자연스러운 편이었다.

앱을 실행해주는 기능도 무리 없이 작동됐다. 이를테면 네이버 지도 열어줘, 인스타그램 열어줘, 라인 열어줄래, 네이버웹툰 열어, 네이버뮤직 열어줘, 페이스북 열어줘, 파파고 열어줘, 배달의민족 열어줘 등과 같은 말에 반응해 사용자 스마트폰에 설치된 해당 앱을 열어준다.

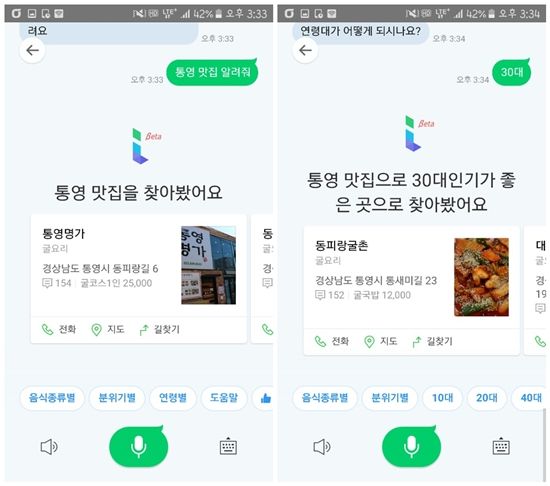

이밖에도 '통영 맛집 알려줘'라는 질문에는 '통영 맛집을 찾아봤어요'라는 말이 표시된다. 여기서 다시 연령별, 분위기별, 음식종류별로 주문을 할 수 있다는 점도 새로웠다.

과거 네이버, 카카오(다음)을 포함해 구글 등 글로벌 인터넷기업들도 음성인식기술을 도입했었지만 그동안에는 대부분 검색결과를 알려주는 선에서 역할이 끝났다. 반면 지난해 인기를 끌었던 아마존 음성인식비서인 알렉사가 적용된 스피커인 아마존 에코가 등장한 이후 자연스러운 맥락을 이해해 대응해주는 기술에 대한 연구가 활발한 만큼 점점 더 이러한 기술이 정교해지고 있는 추세다.

■ '메뉴 고르기' 벗어나려면 더 많은 학습 필요

물론 네이버i에도 개선점은 있었다. 음성이나 채팅창을 통해 입력한 말이 어떤 의도를 가졌는지를 이해해 대응한다는 콘셉트는 좋았지만 여전히 다른 AI 기반 챗봇이나 음성검색이 내세웠던 '메뉴 고르기' 방식에서 크게 벗어나지는 못했다는 점이다.

실제로 사용자가 자신의 비서와 대화하듯 하는 수준엔 아직 이르지 못했다.

음성을 인식한 뒤에 내용을 이해하고, 추가질문을 해서 비교적 정확하게 사용자 의도를 파악하는 수준까지는 왔으나 이러한 과정이 결국에는 화면을 터치해 여러가지 선택사항 중 하나를 고르는 방식으로 진행되는 경우가 많았다. 이런 방식은 사용자가 원하는 답을 보다 직관적으로 얻도록 돕는 역할을 하기는 하지만 결국 자연스러운 대화의 맥을 끊는 결과를 가져오기도 한다.

더구나 파파고앱을 실행하면 되는데 굳이 네이버앱을 실행해서 번역기능을 쓸 이유가 있는지도 아직은 의문이다. 현재 네이버i는 파파고와 연동해 한글을 영어, 중국어, 일본어로 번역해주는 기능을 가졌다.

사용자들은 이 서비스에 대해 "버튼을 눌러야 인식하는 것 말고도 음성으로 부르면 인식을 시작할 수 있도록 해주세요", "음성인식률을 더 높여주세요", "앞에 얘기했던 문맥이 다음 대화에도 반영되었으면 좋겠어요"라는 등 의견을 내기도 했다.

최근 모바일월드콩그레스(MWC)2017에서 기조 연설을 맡은 이데자와 타케시 라인주식회사 최고경영자(CEO)는 '클로바(Clova)'라는 새로운 AI 플랫폼을 처음으로 공개했다. 사람의 오감으로부터 정보를 받아 생활밀착형 서비스를 내놓는다는 것이 목표다. 이를 위해 네이버랩스가 보유한 아미카를 업그레이드하고, 아마존 에코처럼 음성인식비서역할을 할 수 있는 전용 스피커인 '웨이브(WAVE)'와 전용 스마트디스플레이인 '페이스(FACE)'를 내놓겠다는 계획도 밝혔다.

하루에도 수많은 사용자들이 네이버 검색창에 수많은 키워드를 입력해 원하는 정보를 찾아내는 만큼 이 회사가 생활밀착형 AI 비서로 의미있는 성공을 거둘 가능성이 큰 것은 사실이다. 사용자가 궁금해하는 많은 정보들을 네이버 포털을 통해 이미 확보하고 있어서다.

관련기사

- 배달의민족, 100억 투자...음식주문에도 AI 얹는다2017.03.06

- 네이버, 대화 문맥 이해하는 AI 엔진 베타 서비스2017.03.06

- 네이버-라인, 차원 다른 ‘AI비서’ 쏟아낸다2017.03.06

- 네이버-라인, 日 가상홈 로봇 회사 인수2017.03.06

그 초기 성과물 중 하나인 네이버i는 이전보다 말의 흐름을 잘 파악해내는 것은 유사 서비스들과 다른 모습이다.

다만 여전히 스마트폰으로 앱을 실행하거나 검색어를 입력해서 찾는 것이 더 빠른데 굳이 왜 음성인식비서를 써야하는가에 대한 사용자들의 의견에 대해 속시원한 답변을 내놓아야한다는 과제는 남아있다.