앞으로는 영어공부를 할 필요가 없는 것 아니냐는 우스갯소리가 나온다. 그만큼 실시간 번역 품질이 좋아졌단 얘기다.

물론 섬세한 감정이나 역사적인 맥락까지 이해해야 하는 문학 번역은 여전히 기계에겐 버거운 일이다. 하지만 실시간 음성인식 번역 기능을 갖춘 앱만 있으면 실시간 대화는 큰 무리없이 해결할 수 있는 시대가 됐다.

이 분야에서 괄목할 성과를 내고 있는 곳 중 하나가 바로 구글이다.

구글은 2015년 9월부터 번역서비스에 인공지능 기반 기술 중 하나인 '인공신경망'을 이식하기 시작했다. 지난 해 11월부터는 '구글 인공신경망 기계번역(GNMT)'이라는 이름으로 영어, 한국어, 중국어, 일본어 등을 포함한 16개 언어쌍을 지원하기 시작했다.

그 결과는 생각보다 흥미롭다. 이 연구를 맡았던 구글브레인은 위키피디아 및 뉴스매체로부터 샘플문장을 받아 주요 언어조합을 평가대상으로 삼았을 때 GNMT의 번역오류가 55%~85% 가량 줄었다고 설명했다.

인공신경망은 구글은 물론 네이버 파파고, 바이두, 시스트란 등에서도 도입하고 있는 최신 기술이다.

그 동안은 "이런 문장은 이렇게 번역되더라"는 통계에 의존한 구문 기반 번역(PBMT)이 대세였다. 하지만 인공신경망을 활용한 번역은 문장을 통째로 번역한 결과를 수없이 반복학습하면서 보다 정확한 의미를 찾아내는 방식이다. 사실상 사람들이 외국어를 학습하는 것과 같은 방식이다.

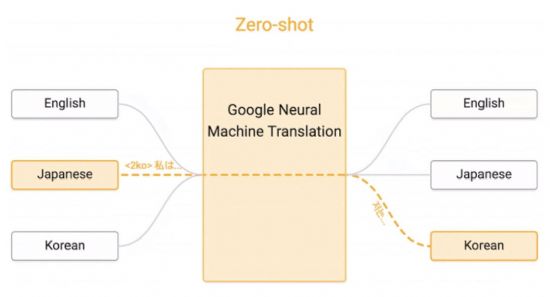

■ 모든 언어 간 교집합 찾아내는 '제로샷' 번역

인공신경망 기반 번역 기술을 연구하고 있는 전문가들이 구글번역에서 보다 주목하고 있는 것은 '제로샷(zero shot)'이다.

기본적으로 인공신경망을 활용해 번역기를 학습시키기 위해서는 어마어마한 컴퓨팅 자원을 필요로 한다. 지난달 초 구글코리아가 개최한 '구글AI포럼'에서 화상 세미나를 통해 구글브레인팀 마이크 슈스터 박사는 "구글번역은 하루에 1천400억개 단어들을 번역한다"며 "하나의 언어쌍에 대한 모델을 학습시키는 경우 100여개 그래픽처리프로세서(GPU)를 2주~3주는 돌려야하고, 최소 1억개 문장이 필요하다"고 말했다.

이 말대로라면 현재 컴퓨팅 자원으로 구글이 지원하는 103개 언어에 대해 모두 번역 서비스를 제공하려면 103의 제곱만큼 언어쌍을 지원해야한다. 구글은 자체 개발한 오픈소스 기반 머신러닝 툴킷인 텐서플로와 이를 운영하기 위한 텐서프로세싱유닛(TPU)를 활용해 컴퓨팅 파워를 효율적으로 사용하고 있지만 아직은 모든 언어쌍에 대한 번역을 서비스하기에는 부족한 실정이다.

구글이 이러한 기술적 어려움을 극복하기 위해 고안해 낸 것이 제로샷 번역이다. 이 묘책은 머신러닝을 통해 이미 번역된 결과를 학습하지 않고서도 서로 다른 나라 언어를 번역할 수 있게 돕는다.

이를 테면 이런 식이다. 구글번역이 영어-한국어, 영어 일본어 언어쌍을 각각 번역할 수 있는 지식을 갖추고 있을 경우 한국어-일본어 언어쌍에 대해서도 별도 머신러닝을 통한 학습과정을 거치지 않아도 번역이 가능해진다는 설명이다.

구글은 '구글 다중 인공신경망 기계번역 시스템:제로샷 번역 활용(Google’s Multilingual Neural Machine Translation system:Enabling Zero-Shot Translation

Enabling Zero-Shot Translation)'이라는 논문에서 "다중 언어들 사이 번역을 위한 단일한 NMT 모델을 사용하면서 모델 아키텍처를 변경할 필요없이 인공 토큰을 입력한 문장을 붙이는 방법으로 필요한 언어로 번역할 수 있게 했다"고 설명했다.

쉽게 말하면 영-한, 영-일 언어쌍에 대한 번역 기술을 갖춘 상태에서 한국어를 일본어로 바꾸기 위해 한국어에 특별한 꼬리표를 달면 알아서 한국어를 영어로 번역한 뒤 다시 일본어로 번역해주는 과정을 거친다.

제로샷 번역은 이 덕분에 여러 언어가 섞여 있는 경우에도 번역을 해낸다.

예를 들면,

■ 서로 다른 언어 같은 뜻끼리 한 곳에…

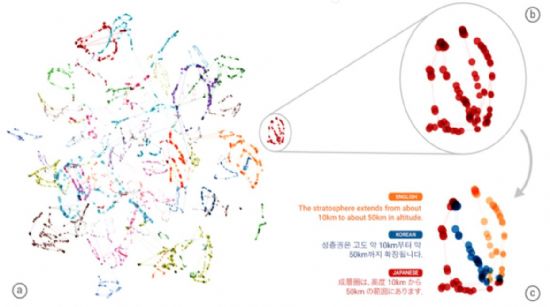

마이크 슈스터 박사는 이 과정에서 흥미로운 결과를 얻게 됐다고 설명했다. 언어는 다르지만 같은 의미를 가진 문장들끼리 같은 클러스터(특정영역)에 모이더라는 것이다.

관련기사

- 소리만 요란했던 인간과 AI의 번역대결2017.03.02

- 싱겁게 끝난 번역대결…인간, AI에 완승2017.03.02

- "AI, 기술 자체보다 용도 고민이 더 중요해져"2017.03.02

- 인공신경망 VS 통계기반 번역, 뭐가 다를까?2017.03.02

이러한 결과는 인공지능이 서로 다른 언어들에 대한 번역결과를 정확치는 않지만 어떤 기준에 따라 하나의 영역으로 분류해 낸다는 점에서 번역 연구에 또 다른 기대감을 준다. 인공 신경망이 여러 언어를 학습하는 자체적인 능력을 갖추고 있다는 점을 보여주기 때문이다.

실제로 구글번역 내부 데이터를 3차원으로 표시해 본 결과 번역 문장을 의미별로 구분한 곳에 '성층권은 고도 약 10km부터 약 50km까지 확장됩니다'라는 문장에 대해 영어, 일본어로 표시된 문장이 같은 색상으로 한 곳에 모여있었다.