한바탕 인공지능(Artificial Intelligence)에 대한 열풍이 지나갔다. 과연 미래에 인공지능이 인간을 능가할 것인가에 관해 많은 사람들이 관심과 동시에 우려를 표했다. 체스, 장기 그리고 바둑같은 복잡한 게임에서 사람을 이기는 기계가 나오고, 퀴즈 대결 같은 지식 정보에서도 사람을 능가하는 인공지능의 발전은 SF 영화에 등장하는 기계를 장악하는 빅브라더의 출현, 또는 사람들의 일자리가없어지지 않을까 하는 막연한 우려를 만들기에 충분했다.

사실 AI 개념은 매우 고전적인 것으로,이른바 기계가 스스로 배우는 기계학습(Machine Learning)의 개념으로 많은 알고리즘이 발전되어 왔다. 2006년 이후로 대용량 데이터를 처리할 수 있는 하드웨어의 발전과 빅데이터의 힘 그리고 소위 딥러닝(Deep Learning)이라고 불리는 인공신 경망 알고리즘의 뚜렷한 개선기법이 나온 후 많은 글로벌 IT 기업이 인공지능을 이용한 서비스 개발에 뛰어들고 있다.

■딥러닝, 고성능 컴퓨팅과 복잡한 기술 장벽?

딥러닝의 가장 대표적인 사례들이 수많은 사진에서 '하늘','바다' 같은 자연이나 각기 다른 '사람얼굴'을 찾고 인식하는 것으로, 사람은 아주 쉽게 분별하는 작업들을 컴퓨터는 계층을 나눈 패턴을 계산해야 하는 매우 복잡한 과정을 거쳐야 사람의 추론과 직관이라는 것이 가능해진다.

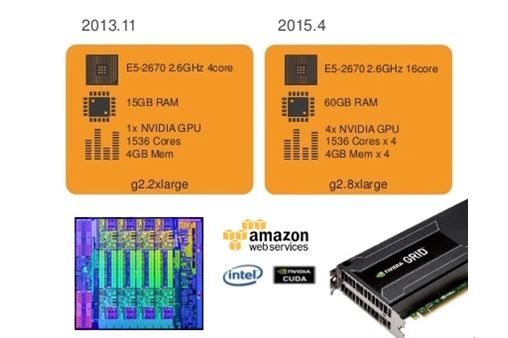

이러한 딥러닝 기술은 대량 연산 능력, 즉 고성능 CPU 컴퓨팅 파워와 이를 동시에 병렬로 처리할 수 있는 가장 핵심적인 하드웨어 요소인 GPU가 필요하다. 이는 우리가 흔히 사용하는 PC 수준이아니라 수천장의 CPU와 수백장의 GPU 코어가 탑재된 컴퓨팅 파워를 기반으로 복잡한 계산을 하는 것으로서 지금까지는 마치 슈퍼컴퓨터를 가진 연구소나 거대 IT 기업의 전유물로 여겨져왔다.

뿐만 아니라 딥러닝이라는 기술은 설명하기도 복잡한 과학자들이 다루는 고급 알고리즘으로서 일반인 뿐만 아니라 소프트웨어 개발자 조차도 이해하기는 매우 어려운 지식이다. 딥러닝에 적용하는 데이터 역시 대용량 빅데이터들로, 이를 적용해서 딥러닝 서비스를 만드는 것은 아무나할 수 없는것 처럼 보인다.

하지만, 딥러닝을 위한 대용량 컴퓨팅 연산능력과 빅데이터 그리고 전문 알고리즘 지식 같은 진입장벽은 클라우드가 주는 자유로 인해 점점 허물어지고 있다. 지금까지 세상의 많은 성공한 기술들의 경우를 보면, 낮은 가격과 보편적인 기술이 되어 누구나 사용하여 아이디어를 실현할 수 있도록 공유되어 왔었다.

■클라우드 컴퓨팅이 가져다주는 기회의 자유

아마존웹서비스 가상 서버에서 이용할 수 있는 인스턴트 중에는 가상 CPU 32장과 GPU 4장그리고 240GB의 SSD를 탑재한 장비를 한시간에 3천원(버지니아리전기준 2.6달러)에 사용할 수 있는 것도 있다. 50대정도의 온디맨드 가상서버를 구축하면 1천500여개의 가상 CPU와 200개의 GPU가 달린 슈퍼컴퓨터를 누구나 시간당 15만원이면 사용할 수 있다.

또한, AWS에서는 스팟 인스턴스라는 개념이 있어 유휴 장비를 경매를 통해 짧은 시간에 빌릴 수 있는 가격 옵션을 제공하는데, 온디맨드 대비 90% 정도 가격이 저렴하기 때문에 경우에 따라 1만 5천원 정도로도 사용 가능하다.

병렬연결된 50대의 가상서버를 켜고 끄고, 필요한 데이터 분석을 진행하는 데는 모두 API를 사용한다. 지금 바로 한국의 사무실 혹은 집에 앉아서 PC 터미널 안에서 간단한 명령어 또는 스크립트만으로 지구 반대편의 나만의 슈퍼컴퓨터를 생성했다 없앨 수 있는 자유가 있다는 것이다.

뿐만 아니라, 많은 딥러닝 알고리즘을 수행하는 소프트웨어 역시 오픈소스로 나와 있다. 엔비디아가 제공하는 GPU 프로그래밍을 위한 라이브러리 CUDA (Compute Unified Device Architecture)를기반으로 Lua 언어로 만들어진 오픈소스 머신러닝 라이브러리인 토치(Torch)를 비롯하여 몬트리올 대학에서개발한 파이선 기반 Theano 라이브러리 그리고 여기서 파생되는 많은 오픈소스 라이브러리가 공급된다. AWS에는 이러한 라이브러리들이 이미 설치돼 앞서 말한 GPU 기반 가상 서버 에바로 활용할 수 있는 부팅 디스크 같은 것을 머신 이미지들을 제공하고 있다.

기계학습 알고리즘에 익숙하지 않은 소프트웨어 개발자들도 아마존이 제공하는 머신러닝 서비스를 이용하면 손쉽게 데이터를 통한 학습, 모델 생성 및 추론을 해 볼 수 있다. 뿐만 아니라 AWS에는 대용량 스토리지, 하둡 클러스터 운영, NoSQL및 데이터웨어하우스 등 다양한 빅데이터 처리를 위한 빌딩 블록이 있어 데이터 수집, 저장과 분석을 바로해 볼 수 있는 장점이 있다.

■개인이나 스타트업 누구나 참여할 수 있다!

제약업체를 위한 분자 모델링 패턴을 연구하는오픈아이사이언티픽(OpenEye Scientific)이나 GPU 기반의 고성능 동영상 렌더링에 필요한 작업을 하는 OTOY, 의료 이미지 데이터를 딥러닝 기법으로 분석하는 버터플라이네트워크(Butterfly Network) 등 스타트업도 AWS의 고성능 클라우드 컴퓨팅을 선택함으로서 최신 AI 기술을 활용 가능한 자유를 얻게 되었다.

전세계적인 온라인 동영상 업체인 넷플릭스 역시 AWS의 GPU 인스턴스를 기반으로 다양한 딥러닝 기술을 적용할 수 있는 노하우를 공개하기도 했으며, 유명 개발자 커뮤니티인 레딧(Reddit)에서도 많은 개인들이 AWS에서 딥러닝 적용을 위한 팁을 공유하고 있다.

AWS 퍼블릭데이터 세트에는 대용량 공공 데이터를 무상으로 제공해주는 서비스도 있다. 과거에는 인간 게놈 매핑같은 대규모 데이터 세트를 찾아 다운로드 하고, 가공 및 분석하려면 오랜 시간이걸렸지만 AWS에서 바로 찾아서 빅데이터 분석이 가능해졌다. 이러한 데이터에는 NASA가 보유한 고해상도 위성사진인 LANSAT, 전세계 일기 정보인 NEXRAD, 암 게놈 데이터인 TCGA를 비롯 천문학, 생물, 기후 및 경제와 언어 데이터 등 수많은 정보를 얻고 이를 활용할 수도 있다.

관련기사

- 마이크로서비스를 위한 AWS 빌딩 블록 이해하기2016.03.23

- 클라우드 기술에 대한 세 가지 패러다임 변화2016.03.23

- "웹 파편화는 필연…표준 기다리지 마라"2016.03.23

- 왜 우리는 아마존처럼 API 사업 못하지?2016.03.23

NASA의 제트 추진 연구소는 화성에 보낸 무인 로봇 탐사선 인큐리오시티의 빠른 의사 결정과 동작을 위해 AWS와 인텔의 수백개 고성능 컴퓨팅 인스턴스를 활용하여 12테라플롭스의 데이터를 40달러 수준의 비용으로 분석할 수 있다는 것도 보여 주었다. 로봇 공학적 계산이나 극지역 기후 분석, 원할 때마다 언제든지 클라우드의 컴퓨팅 파워를 얻을 수 있어 AWS 고성능컴퓨팅(High Performance Computing)의 혜택으로 비용과 시간을 크게 줄여, 문제 해결을 위한 연구에 더 집중할 수 있게 되었다.

AI 기술의 발전이 많은 사회적 경제적 우려를 낳고 있지만, 클라우드 컴퓨팅이 가져온 혁신과 변화로 인해 누구나 그 기술의 주인이 될 수 있는 자유를 얻을 수 있다. 그렇게 된다면 인공지능으로 인한 빅브라더의 출현과 기계의 지배라는 막연한 불안 보다는 기계와 인간의 협력적 공존이 가능할 것이다. 클라우드를 통해 더 많은 사람들이 인공지능을 활용해 우리의 삶을 윤택하게 할 수 있는많은 발명과 혁신을 꾀하기를 기대해 본다.

*본 칼럼 내용은 본지 편집방향과 다를 수 있습니다.