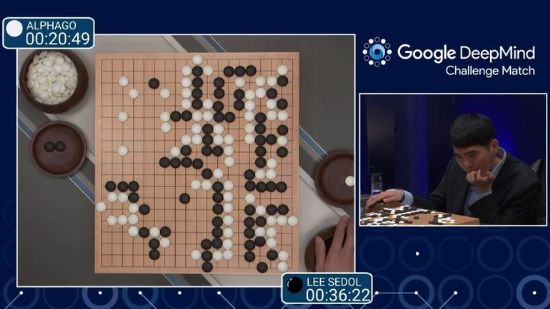

딥러닝을 수행하는 알파고로 이세돌 9단과 바둑대결에서 승리하며 세상을 놀라게 했던 구글 딥마인드가 이번에는 더 복잡한 업무를 빠르게 스스로 수행할 수 있는 '언리얼(UNREAL)'이라는 알고리즘을 연구한 결과를 공개했다. 이를 통해 사람들이 가르쳐주지 않고서도 직접 학습하는 일이 가능해질 것이라는 전망이다. 영화 속에서나 봤던 진짜 인공지능이 더 가까이 다가오고 있다는 뜻이다.

18일(현지시간) 지디넷 등 외신에 따르면 딥마인드 연구원들은 최근 논문(관련링크)을 통해 '비지도, 강화, 보조학습( UNsupervised REinforcement and Auxiliary Learning)의 앞 글자를 딴 언리얼이라는 알고리즘을 공개했다. 이는 동물들이 꿈을 꾸면서 빠르게 먹이를 찾는 방법을 배우는데서 착안했다.

연구원들은 아타리가 제작한 게임과 3D게임인 레비린스를 활용해 테스트를 수행했다. 그 결과 언리얼이 이전 인공지능 관련 알고리즘 보다 10배 빠르게 해당 게임들을 능숙하게 다룰 수 있었다. 레비린스의 경우 이 게임 전문가와 비교해 평균 87% 수준까지 게임능력을 따라잡았다는 분석이다.

딥마인드 연구원들은 이전에 알파고에 쓰였던 것처럼 바둑이나 아타리가 제작한 2600여개 게임을 대상으로 강화학습을 시켰다.

언리얼은 여기에 2가지 추가적인 업무를 수행하며 학습능력을 강화한다. 하나는 동물이 꿈을 꾸는 렘(REM) 수면 시간 동안 음식을 찾기 위한 경로를 학습한다는 점이다. 두번째로는 아기들이 운동기능을 훈련하는 과정에서 착안했다.

논문은 "동물들이 꿈을 꾸는 동안 긍정적인 혹은 부정적인 보상을 받는 과정을 더 빠르게 수행하는 방법에 착안해 (언리얼이) 이러한 과정을 반복하도록 했다"고 설명했다. 최근까지 학습을 통해 얻은 경험을 바탕으로 시각적인 단서에 집중해 더 빠르게 목표를 수행할 수 있는 방법을 찾으면 더 많은 보상을 주는 방식을 활용했다는 것이다.

관련기사

- MS, 엘론 머스크 주도 AI 연구소와 협력2016.11.19

- 구글 번역, 인공지능으로 더 똑똑해진다2016.11.19

- 인간처럼 만져보고 판별하는 'AI 로봇' 개발2016.11.19

- 비브 손잡은 삼성 "갤S8, AI 혁명 시작점"2016.11.19

또 다른 작업은 화면에 비친 픽셀을 제어하는 방법으로 주어진 게임에서 어떻게 하면 더 많은 보상을 얻을 수 있는지를 스스로 학습하게 한 것이다. 딥마인드 연구원들은 57개 아타리 게임과 레비린스 13레벨에서 테스트를 수행했다.

딥마인드의 핵심 목표는 인공지능 프로그램이 사람이 가르치는 일 없이 스스로 알아서 복잡한 문제를 처리할 수 있도록 하는 것이다. 이들은 "새로 개발한 알고리즘이 더 복잡한 환경에서 많은 일들을 해낼 수 있을 것"으로 기대했다.